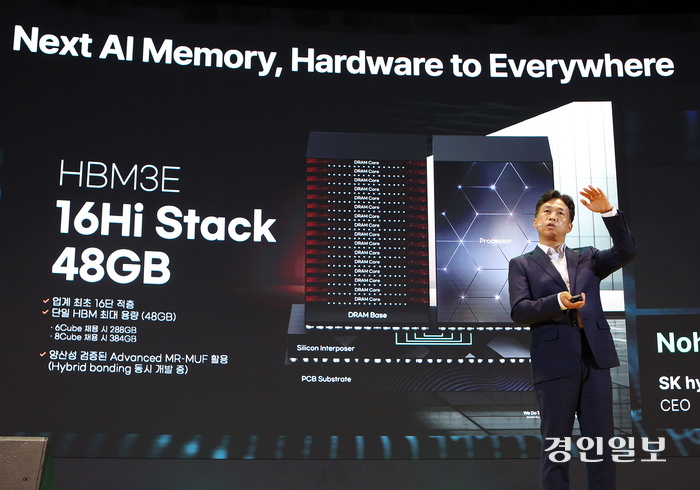

SK하이닉스가 현존 HBM(고대역폭메모리) 최대 용량인 48GB(기가바이트)가 구현된 16단 HBM3E 개발을 처음으로 공식화했다. 이는 기존 12단을 넘어선 HBM3E 최고층 제품으로 내년 양산이 예상된다.

곽노정 SK하이닉스 대표이사 사장은 4일 서울 삼성동 코엑스에서 열린 ‘SK AI 서밋(Summit) 2024’에서 ‘차세대 AI 메모리의 새로운 여정, 하드웨어를 넘어 일상으로’를 주제로 한 기조 연설을 통해 이같이 밝혔다.

곽 사장은 “현재 세계 최초로 개발, 양산하고 있는 ‘월드 퍼스트(World First)’ 제품을 다양하게 준비 중”이라며 “당사는 기술 안정성을 확보하고자 48GB 16단 HBM3E를 개발 중”이라고 말했다.

HBM(High Bandwidth Memory)은 여러 개의 D램을 수직으로 연결해 기존 D램보다 데이터 처리 속도를 혁신적으로 끌어올린 고부가가치, 고성능 제품이다.

HBM은 1세대(HBM)-2세대(HBM2)-3세대(HBM2E)-4세대(HBM3)-5세대(HBM3E) 순으로 개발됐다. 기존 12단 HBM3E의 용량은 3GB D램 단품 칩 12개를 적층한 36GB였다.

곽 사장은 “16단 HBM3E를 생산하기 위해 당사는 12단 제품에서 양산 경쟁력이 입증된 어드밴스드(Advanced) MR-MUF 공정을 활용할 계획이며, 백업 공정으로써 하이브리드 본딩(Hybrid bonding) 기술도 함께 개발하고 있다”고 했다.

MR-MUF(Mass Reflow-Molded Under Fill)는 반도체 칩을 쌓아 올린 뒤 칩과 칩 사이 회로를 보호하기 위해 액체 형태의 보호재를 공간 사이에 주입하고, 굳히는 공정이다.

칩을 하나씩 쌓을 때마다 필름형 소재를 깔아주는 방식 대비 공정이 효율적이고, 열 방출에도 효과적이라는 평가. 특히 SK하이닉스의 어드밴스드 MR-MUF는 기존 공정보다 칩을 쌓을 때 가해지는 압력을 줄이고, 휨 현상 제어(Warpage control)도 우수해 안정적인 HBM 양산성을 확보하는 데 핵심이 되고 있다.

16단 HBM3E는 내부 분석 결과 12단 제품 대비 학습 분야에서 18%, 추론 분야에서는 32% 성능이 향상됐다. 향후 추론을 위한 AI 가속기 시장이 커질 것으로 예상되는 가운데, 16단 HBM3E는 향후 당사의 AI 메모리 No.1 위상을 더욱 공고히 해줄 것으로 기대하고 있다.

또한 곽 사장은 시간의 흐름에 따른 메모리의 개념 변화를 설명하고 AI시대를 이끌어 가고 있는 SK하이닉스의 기술력과 제품을 소개했다.

최고의 경쟁력을 갖춘 ‘비욘드 베스트(Beyond Best)’ 제품과 AI 시대에 시스템 최적화를 위한 ‘옵티멀 이노베이션(Optimal Innovation)’ 제품이 대표적이다.

비욘드 베스트 제품에 대해서는 저전력 고성능을 강점으로, 향후 PC와 데이터센터에 활용될 것으로 전망되는 LPCAMM2 모듈을 언급했다. 또한 1cnm 기반 LPDDR5와 LPDDR6도 개발 중이라며 낸드에서는 PCIe 6세대 SSD와 고용량 QLC 기반 eSSD, 그리고 UFS 5.0을 준비 중이라고 했다.

LPCAMM2(Low Power Compression Attached Memory Module 2)는 LPDDR5X 기반의 모듈 솔루션 제품으로 기존 DDR5 SODIMM 2개를 LPCAMM2 1개로 대체하는 성능 효과를 가지면서 공간 절약뿐만 아니라 저전력과 고성능 특성을 구현한다.

PCIe(Peripheral Component Interconnect express) 디지털 기기의 메인보드에서 사용하는 직렬 구조의 고속 입출력 인터페이스이며 QLC(Quadruple Level Cell) 낸드플래시는 데이터 저장 방식에 따라 ▲셀 하나에 1비트를 저장하는 SLC(Single Level Cell) ▲2비트를 저장하는 MLC(Multi Level Cell) ▲3비트를 저장하는 TLC(Triple Level Cell) ▲4비트를 저장하는 QLC로 구분된다.

동일한 셀을 가진 SLC 대비 QLC는 4배 더 많은 데이터를 저장할 수 있어 고용량을 구현하기 용이하고 생산원가 효율성도 높다.

곽 사장은 “더 나아가 SK하이닉스는 HBM4부터 베이스 다이(Base Die)에 로직 공정을 도입할 예정”이라며 “글로벌 1위 파운드리 협력사와의 원팀 파트너십을 기반으로 고객에게 최고의 경쟁력을 갖춘 제품을 제공하겠다”고 밝혔다.

베이스 다이(Base Die)는 GPU와 연결돼 HBM을 컨트롤하는 역할을 수행하는 다이다. HBM은 베이스 다이 위에 D램 단품 칩인 코어 다이(CoreDie)를 쌓아 올린 뒤 이를 TSV 기술로 수직 연결해 만들어진다.

옵티멀 이노베이션 전략도 공개했다.

곽 사장은 “커스텀(Custom) HBM은 용량과 대역폭, 부가 기능 등 고객의 다양한 요구를 반영해 성능을 최적화한 제품으로, 향후 AI 메모리의 새로운 패러다임이 될 것”이라고 말했다.

이어 “AI 시스템 구동을 위해서는 서버에 탑재된 메모리 용량이 대폭 증가해야 한다. 이를 위해 당사는 여러 메모리를 연결해 대용량을 구현하는 CXL을 준비 중이며, 초고용량 QLC eSSD를 개발해 고객이 더 많은 데이터를 더 작은 공간에서 저전력으로 이용할 수 있도록 준비하겠다”고 덧붙였다.

CXL(Compute Express Link)은 고성능 컴퓨팅 시스템에서 CPU/GPU, 메모리 등을 효율적으로 연결해 대용량, 초고속 연산을 지원하는 차세대 인터페이스이다.

곽 사장은 “메모리 병목 현상을 극복하기 위해 메모리에 연산 기능을 더하는 기술을 개발하고 있다. PIM(Processing in Memory), 컴퓨테이셔널 스토리지(Computational Storage) 같은 기술은 초거대 데이터를 다루게 될 미래의 필수 기술로 차세대 AI 시스템의 구조를 바꾸는 큰 도전이자 AI 업계의 미래가 될 것”이라고 말했다.

이어 “‘World First, Beyond Best, Optimal Innovation’ 세 방향성을 미래 발전의 가이드라인으로 삼고 고객과 파트너, 이해관계자들과의 긴밀한 다중(多重) 협력을 통해 ‘풀스택 AI 메모리 프로바이더(Full Stack AI Memory Provider)’를 목표로 지속 성장하도록 노력하겠다”고 덧붙였다.